A continuación reproduzco un documento en el cual el Relator Especial de las Naciones Unidas (ONU) para la Libertad de Opinión y de Expresión y la Relatora Especial para la Libertad de Expresión de la Comisión Interamericana de Derechos Humanos de la OEA consideran necesario poner de presente una serie de principios jurídicos internacionales sobre la materia con ocasión de los eventos recientes relacionados con los programas de espionaje estatales. Lo comparto con la idea de que iniciemos el debate y lo incorporemos a nuestras discusiones diarias sobre sociedad y tecnología. El Documento original esta disponible aquí (los resaltados en color son míos)

Relator Especial de las Naciones Unidas (ONU) para la Protección y Promoción del Derecho a la Libertad de Opinión y de Expresión

Relatora Especial para la Libertad de Expresiónde la Comisión Interamericana de Derechos Humanos de la OEA

Declaración conjunta sobre programas de vigilancia y su impacto en la libertad de expresión

21 de junio de 2013 – Ante los acontecimientos relacionados con la divulgación de programas secretos de vigilancia destinados a la lucha contra el terrorismo y a la defensa de la seguridad nacional que podrían afectar de manera severa el derecho a la libertad de pensamiento y expresión y el derecho a la intimidad de las personas, el Relator Especial de las Naciones Unidas (ONU) para la Libertad de Opinión y de Expresión y la Relatora Especial para la Libertad de Expresión de la Comisión Interamericana de Derechos Humanos de la OEA consideran necesario poner de presente una serie de principios jurídicos internacionales sobre la materia.

En los últimos días se ha conocido el alcance de algunos programas de vigilancia de la Agencia de Seguridad Nacional de los Estados Unidos (NSA – por sus siglas en inglés) sobre metadatos de comunicaciones telefónicas y contenido de informaciones digitales. Según la información disponible, dichos programas estarían amparados en la Ley de Vigilancia de Inteligencia Extranjera (FISA – por sus siglas en inglés) y la Ley Patriota (Patriot Act), contarían con supervisión de una corte independiente que opera de manera reservada y estarían sometidos al control reservado de comités especiales del Congreso de los Estados Unidos. No obstante, como se menciona adelante, la información disponible sobre el alcance de estos programas pone de presente los riesgos que su implementación apareja para el derecho a la intimidad y a la libertad de pensamiento y expresión de las personas, así como la necesidad de revisar la legislación correspondiente y de establecer mayores mecanismos de transparencia y discusión pública de dichas prácticas.

De la misma manera, según la información recogida en informes temáticos y de país de las relatorías especiales, autoridades de otros Estados americanos, amparados por leyes de inteligencia, o al margen de la regulación legal existente, habrían interceptado las comunicaciones de particulares, en muchos casos con criterios o finalidades políticas e, incluso, las habrían difundido masivamente, sin autorización de su titular, en medios de comunicación estatales. Los relatores especiales habrían conocido también de importantes avances en las investigaciones judiciales de algunos de estos casos de espionaje ilegal.

En este contexto, los relatores especiales reiteran su preocupación por la existencia de programas y prácticas de seguridad que puedan generar un perjuicio serio a los derechos a la intimidad y a la libertad de pensamiento y expresión. En consecuencia, instan a las autoridades correspondientes a que revisen la legislación pertinente y modifiquen sus prácticas, con la finalidad de asegurar su adecuación a los principios internacionales en materia de derechos humanos. A efectos de recordar su doctrina en esta área y asistir a los Estados en el cumplimiento de sus obligaciones legales internacionales correspondientes, los relatores especiales decidieron elaborar y difundir la presente Declaración Conjunta que contiene los principios básicos de derecho internacional que sirven para orientar el diseño e implementación de los programas de vigilancia destinados a la lucha contra el terrorismo y a la defensa de la seguridad nacional.

La importancia de garantizar la seguridad nacional con arreglo a estándares internacionales en materia de derechos humanos

1. En sus diversos informes y declaraciones los relatores especiales han indicado, recogiendo las apreciaciones de otros órganos internacionales de derechos humanos, que el terrorismo es una amenaza cierta y significativa contra la protección de los derechos humanos, la democracia, la paz y la seguridad regionales e internacionales. A partir de su obligación de garantizar a las personas el ejercicio libre de sus derechos, los Estados han adoptado medidas de distinta índole para prevenir y contrarrestar el terrorismo, incluidas la formulación de leyes y procedimientos internos para prevenir, investigar, judicializar y sancionar estas actividades, y la negociación de tratados multilaterales sobre cooperación entre los Estados en la lucha contra el terrorismo.

2. Al tomar iniciativas para prevenir y contrarrestar actividades terroristas, los Estados deben cumplir sus obligaciones internacionales, incluidas las asumidas dentro de los marcos del derecho internacional de los derechos humanos y del derecho internacional humanitario. Las relatorías especiales han evaluado en previos informes sobre países y en informes temáticos y declaraciones conjuntas las implicaciones para la libertad de expresión de las iniciativas antiterroristas adoptadas por los Estados. En tal sentido, han subrayado sistemáticamente que el respeto irrestricto del pleno goce de los derechos humanos, o de los derechos que no hayan sido legítimamente suspendidos en situaciones de emergencia, debe ser parte fundamental de cualquier estrategia antiterrorista.

3. En su reciente informe sobre vigilancia de comunicaciones y sus implicancias en el ejercicio de los derechos a la privacidad y libertad de expresión (A/HRC/23/40) el Relator Especial de las Naciones Unidas (ONU) para la Protección y Promoción del Derecho a la Libertad de Opinión y de Expresión reconoce que la protección de la seguridad nacional puede justificar el uso excepcional de vigilancia en las comunicaciones privadas. Sin embargo, es fundamental comprender que dado el carácter dinámico de los avances en Internet y en la tecnología de las comunicaciones en general, este tipo de vigilancia puede constituir un acto particularmente invasivo que afecta seriamente el derecho a la privacidad y la libertad de pensamiento y expresión.

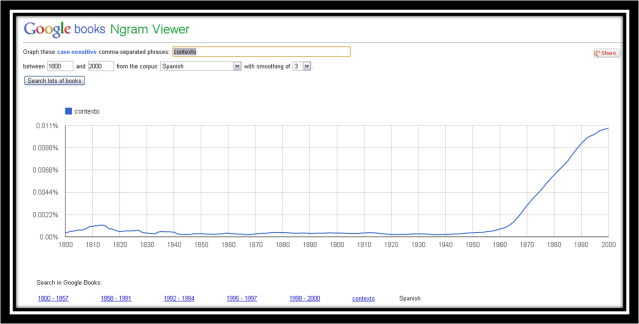

4. En efecto, en los últimos años la tecnología disponible a los Estados para captar y monitorear comunicaciones privadas ha cambiado vertiginosamente. Internet ha creado oportunidades sin precedentes para la libre expresión, comunicación, búsqueda, posesión e intercambio de información. Con ello, se ha facilitado el desarrollo de grandes cantidades de datos acerca de las personas, que incluye, entre otros, su ubicación, actividades en línea, y con quiénes se comunican. Toda esta información, manejada en archivos, accesible y sistematizable, puede ser altamente reveladora. Por ello, su uso por parte de las agencias policiales y de seguridad, en programas de vigilancia destinados a la lucha contra el terrorismo y a la defensa de la seguridad nacional, se ha incrementado sin regulación adecuada en la mayoría de los Estados en nuestra región.

5. Resulta preocupante que la legislación en materia de inteligencia y seguridad haya permanecido inadecuada frente a los desarrollos de las nuevas tecnologías en la era digital. Preocupan de manera especial los efectos intimidatorios que el acceso indiscriminado a datos sobre la comunicación de las personas pueda generar sobre la libre expresión del pensamiento, búsqueda y difusión de información en los países de la región.

6. Existe una necesidad urgente de que los Estados revisen su legislación para establecer los límites a la potestad para vigilar las comunicaciones privadas, su necesidad y proporcionalidad, de conformidad con los derechos de las personas y los principios de derecho internacional que han sido recogidos, entre otros, en el informe sobre vigilancia de comunicaciones y sus implicancias en el ejercicio de los derechos a la privacidad y libertad de expresión (A/HRC/23/40) del Relator Especial de las Naciones Unidas para la Protección y Promoción del Derecho a la Libertad de Opinión y de Expresión y el informe sobre Terrorismo y Derechos Humanos de la Comisión Interamericana de Derechos Humanos (OEA/Ser.L/V/ll.116 Doc. 5 rev. 1 corr).

La necesidad de limitar los programas de vigilancia

7. Los derechos a la privacidad y a la libre circulación del pensamiento e información se encuentran protegidos por el derecho internacional de los derechos humanos. La Declaración Universal de los Derechos Humanos, el Pacto Internacional de los Derechos Civiles y Políticos, la Convención Americana sobre Derechos Humanos y la Declaración Americana de Derechos y Deberes del Hombre reconocen de manera expresa el derecho de toda persona, sin discriminación, a manifestar libremente su pensamiento y a buscar y recibir informaciones de toda índole. Asimismo, prohíben injerencias arbitrarias o abusivas en la vida privada, incluidas las comunicaciones, y a obtener la protección del Estado contra ese tipo de injerencias.

8. De conformidad con lo anterior, los Estados deben garantizar que la intervención, recolección y uso de información personal, incluidas todas las limitaciones al derecho de la persona afectada a acceder a información sobre las mismas, estén claramente autorizadas por la ley a fin de proteger a la persona contra interferencias arbitrarias o abusivas en sus intereses privados. La ley deberá establecer límites respecto a la naturaleza, alcance y duración de este tipo de medidas, las razones para ordenarlas, las autoridades competentes para autorizar, ejecutar y supervisarlas y los mecanismos legales para su impugnación.

9. Dada la importancia del ejercicio de estos derechos para el sistema democrático, la ley debe autorizar el acceso a las comunicaciones y a datos personales sólo en las circunstancias más excepcionales definidas en la legislación. Cuando se invoque la seguridad nacional como razón para vigilar la correspondencia y los datos personales, la ley debe especificar claramente los criterios que deben aplicarse para determinar los casos en los cuales este tipo de limitaciones resulta legítimo. Su aplicación deberá autorizarse únicamente cuando exista un riesgo cierto respecto de los intereses protegidos, y cuando ese daño sea superior al interés general de la sociedad en función de mantener el derecho a la privacidad y a la libre expresión del pensamiento y circulación de información. La entrega de esta información debe ser monitoreada por un organismo de control independiente y contar con garantías suficientes de debido proceso y supervisión judicial, dentro de las limitaciones permisibles en una sociedad democrática.

10. La vigilancia de las comunicaciones y las injerencias a la privacidad que excedan lo estipulado en la ley, que se orienten a finalidades distintas a las autorizadas por ésta o las que se realicen de manera clandestina deben ser drásticamente sancionadas. Esta injerencia ilegítima incluye aquellas realizada por motivos políticos contra periodistas y medios de comunicación independientes.

11. Las empresas que proveen servicios de comunicaciones a través de Internet, publicidad u otros servicios relacionados deben esforzarse para asegurar que se respetan los derechos de sus clientes a la protección de sus datos y de usar Internet sin interferencias arbitrarias. Se alienta a estas empresas para que trabajen en forma conjunta para resistir intentos de ejecutar programas de vigilancia masiva en oposición a los principios aquí establecidos.

Deberes de publicidad y transparencia

12. Toda persona tiene derecho a acceder a información bajo el control del Estado. Este derecho incluye la información que se relaciona con la seguridad nacional, salvo las precisas excepciones que establezca la ley, siempre que estas resulten necesarias en una sociedad democrática. Las leyes deben asegurar que el público pueda acceder a información sobre los programas de vigilancia de comunicaciones privadas, su alcance y los controles existentes para garantizar que no puedan ser usados de manera arbitraria. En consecuencia, los Estados deben difundir, por lo menos, información relativa al marco regulatorio de los programas de vigilancia; los órganos encargados para implementar y supervisar dichos programas; los procedimientos de autorización, de selección de objetivos y de manejo de datos, así como información sobre el uso de estas técnicas, incluidos datos agregados sobre su alcance. En todo caso, los Estados deben establecer mecanismos de control independientes capaces de asegurar transparencia y rendición de cuentas sobre estos programas.

13. El Estado debe permitir a los proveedores de servicios informar a sus clientes acerca de los procedimientos que ellos implementan en respuesta a solicitudes de vigilancia del Estado, y aportar cuando menos, información agregada sobre el número y el alcance de las solicitudes que reciben. En este contexto, los Estados deben hacer esfuerzos por elevar la conciencia de las personas sobre sus derechos y el funcionamiento de las nuevas tecnologías de comunicaciones de manera que puedan determinar, manejar, mitigar y adoptar decisiones informadas respecto de su uso.

14. El Estado tiene la obligación de divulgar ampliamente la información sobre programas ilegales de vigilancia de comunicaciones privadas. Esta obligación debe ser satisfecha sin perjuicio del derecho a la información personal de quienes habrían sido afectados. En todo caso, los Estados deben adelantar investigaciones exhaustivas para identificar y sancionar a los responsables de este tipo de prácticas e informar oportunamente a quienes han podido ser víctima de las mismas.

Protección frente a sanciones ulteriores por la divulgación de información reservada

15. Bajo ninguna circunstancia, los periodistas, integrantes de medios de comunicación o miembros de la sociedad civil que tengan acceso y difundan información reservada sobre este tipo de programas de vigilancia, por considerarla de interés público, pueden ser sometidas a sanciones ulteriores. En igual sentido, las fuentes confidenciales y materiales relacionadas con la divulgación de información reservada deben ser protegidas por la ley. Los mecanismos periodísticos de autorregulación han contribuido significativamente a desarrollar buenas prácticas sobre cómo abordar y comunicar temas complejos y sensibles. La responsabilidad periodística es especialmente necesaria cuando se reporta información en materia de terrorismo y seguridad nacional. Los códigos de ética periodísticos resultan de utilidad para el logro de este propósito.

16. Como ya lo han manifestado de manera reiterada los relatores especiales, una persona vinculada al Estado, que teniendo la obligación legal de mantener confidencialidad sobre cierta información, se limita a divulgar al público aquella que razonablemente considere que evidencia la comisión de violaciones de derechos humanos («whistleblowers»), no debe ser objeto de sanciones legales, administrativas o laborales siempre que haya actuado de buena fe, de conformidad con los estándares internacionales sobre la materia.

17. Cualquier intento de imponer sanciones ulteriores contra quienes revelan información reservada debe fundamentarse en leyes previamente establecidas, aplicadas por órganos imparciales e independientes, con garantías plenas de debido proceso, incluyendo el derecho de recurrir el fallo. La imposición de sanciones penales debe ser excepcional, sujeta a límites estrictos de necesidad y proporcionalidad.